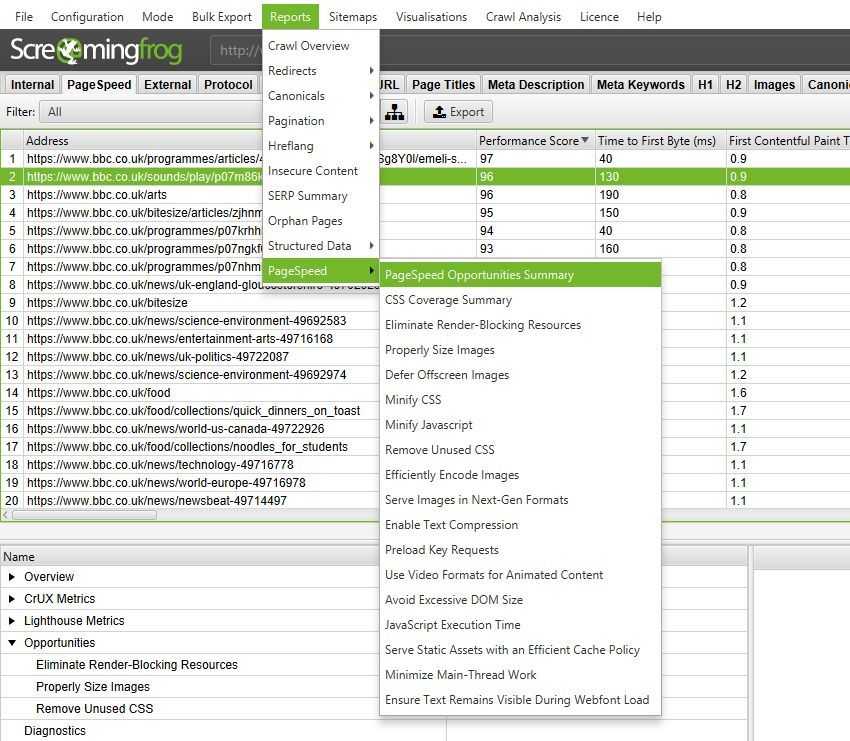

1) Интеграция PageSpeed Insights – метрики Lighthouse, и возможности и данные CrUX

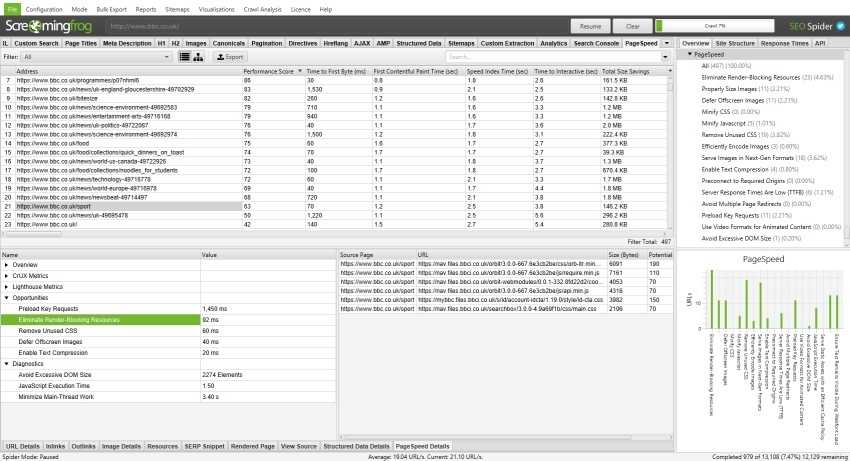

Теперь вы можете анализировать данные о скорости сайта. Добавлена новая вкладка PageSpeed и интегрирован PSI API, который использует Lighthouse и позволяет включать данные Chrome User Experience Report (CrUX) и метрики Lighthouse, а также определять возможные пути увеличения скорости загрузки и проводить масштабную диагностику работы ресурса.

Полевые данные CrUX мегаполезны, когда вам нужно понять, насколько комфортно пользоваться сайтом реальным юзерам, а данные Lighthouse незаменимы для решения любых проблем со скоростью. Самое замечательное в API – вам не нужно использовать JavaScript-рендеринг, вся работа по сути выполняется за вас.

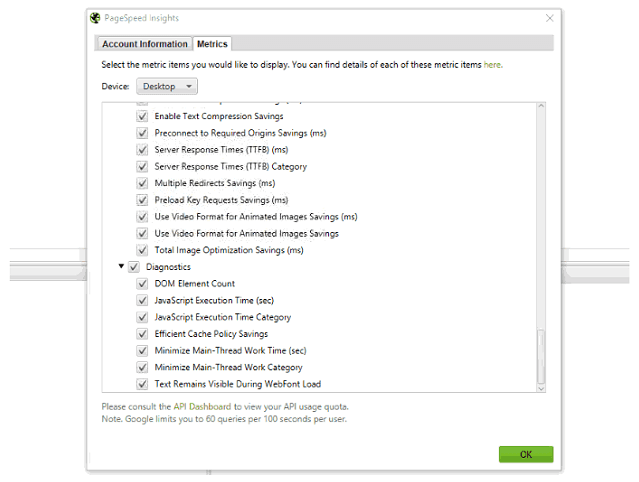

Можно подключить и настроить более 75 метрик, возможностей и средств диагностики (Config > API Access > PageSpeed Insights > Metrics) – для глубокого анализа и “умных” методов улучшения скорости работы.

Во вкладке PageSpeed можно посмотреть такие показатели, как оценка производительности, TTFB, первая отрисовка контента, индекс скорости загрузки, время загрузки для взаимодействия, а также размер страницы, потенциальная экономия по размеру и времени - и многое другое.

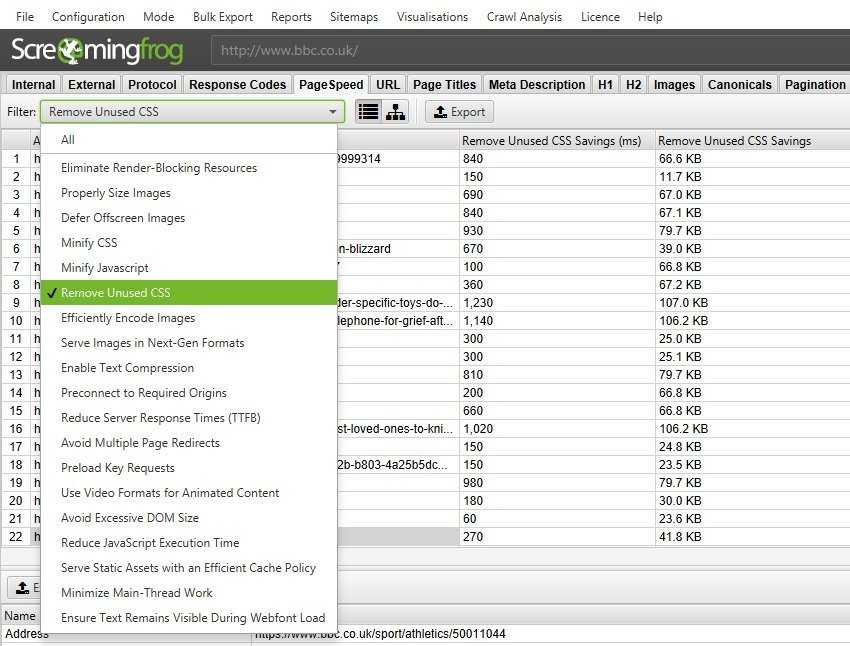

Есть 19 фильтров для возможностей и диагностики, чтобы помочь определить потенциальные меры по улучшению скорости от Lighthouse.

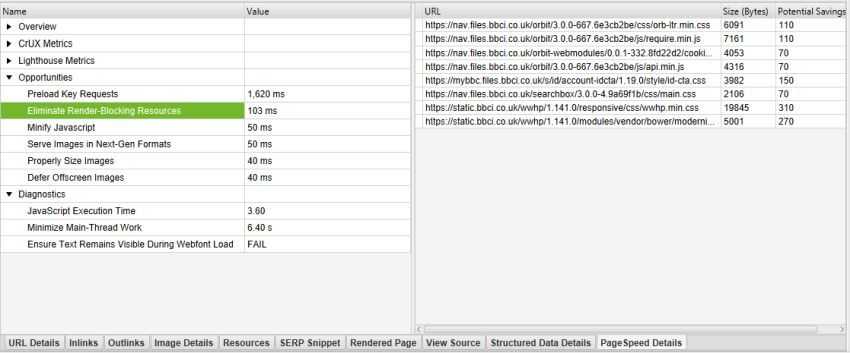

Нажмите на URL-адрес в верхнем окне и затем на вкладку PageSpeed Details снизу – в нижнем окне отобразится список метрик для данного адреса, а также возможные улучшения в порядке наибольшей потенциальной экономии по оценке Lighthouse.

Кликнув на конкретную возможность из списка слева, справа отобразится более подробная информация – на каких именно элементах страницы можно «сэкономить».

Само собой, все данные можно экспортировать одним файлом, кликнув на пункт «Report». В отчёте PageSpeed Opportunities Summary собраны все обнаруженные на сайте возможности (по адресам), а также потенциальная экономия по размеру и миллисекундам.

Наряду с массовым экспортом для каждой возможности имеется отчет по CSS, в котором указывается, какая часть каждого файла CSS не используется во время сканирования и потенциальная экономия.

Обратите внимание, что использование PageSpeed Insights API (например, интерфейса) может повлиять на аналитику. Google знает об этой проблеме, и у у разработчиков есть FAQ о том, как настроить исключающий фильтр, чтобы он не раздувал данные аналитики.

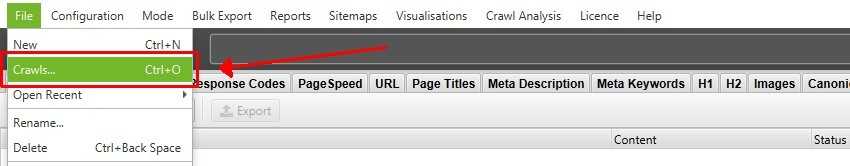

2) Автосохранение и быстрое открытие файлов

В прошлом году разработчики ввели возможность хранения данных на ПК, позволяя сохранять результаты сканирования на диск в базе данных, а не просто хранить их в оперативной памяти – это позволило “пауку” сканировать очень большие сайты.

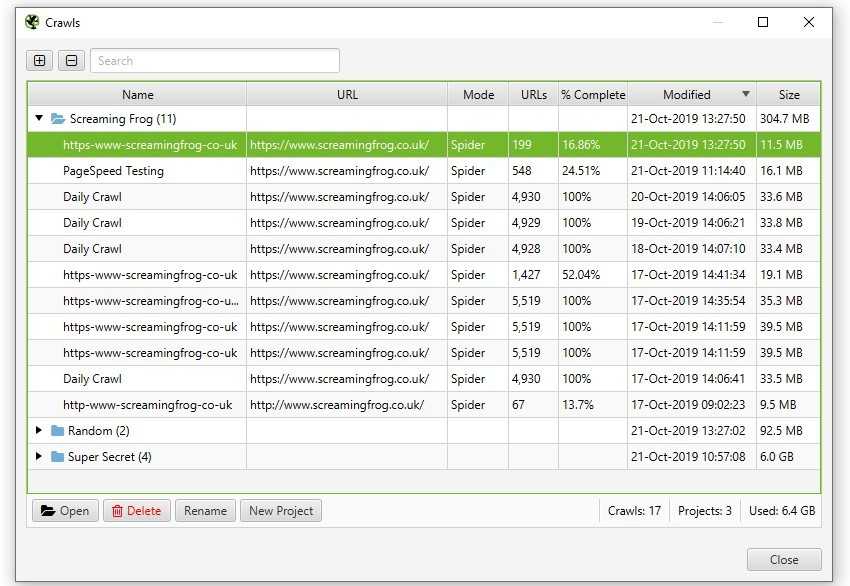

Учитывая фидбек пользователей, разработчики пошли еще дальше. В режиме Database Storage вам больше не нужно сохранять краулы (в виде файла .seospider), они будут сохраняться в базе данных автоматически и доступны через пункт меню File > Crawls...

Данный пункт отображает общую информацию обо всех сохраненных сканированиях, позволяет отрывать их, переименовывать, организовывать в папки, дублировать, экспортировать или массово удалять.

Основное преимущество этого параметра заключается в том, что повторное открытие файлов из базы данных происходит значительно быстрее, чем открытие файлов .seospider. Вам больше не нужно загружать файлы .seospider, что раньше могло занимать значительное время для очень больших проектов. База данных открывается гораздо быстрее, а зачастую мгновенно.

Вам также не придется сохранять краулы вручную, они будут автоматически добавляться в базу данных Но это значит, что вам нужно будет иногда удалять сканирования, которые вы не хотите хранить (есть массовое удаление).

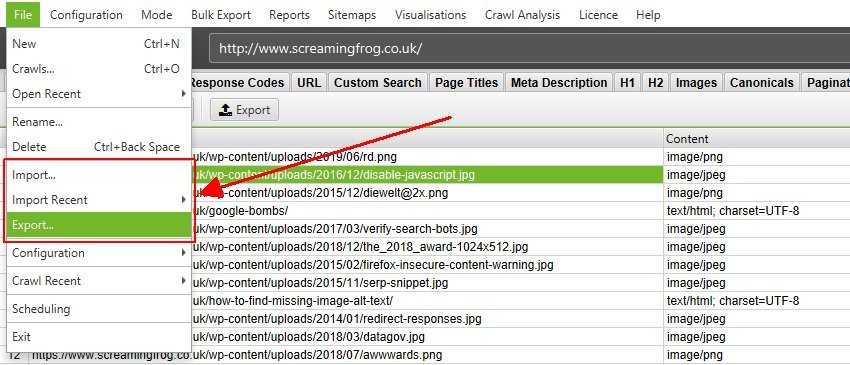

Вы можете экспортировать результаты сканирования и делиться ими с коллегами, или экспортировать как файл .seospider для тех, кто все еще использует режим хранения в ОЗУ. Естественно, вы также можете открывать файлы .seospider в режиме Database Storage. После преобразования (которое может занять некоторое время, как и в версии 11), они будут скомпилированы и доступны для повторного (практически мгновенного) открытия. Параметры экспорта и импорта доступны в меню «File» в режиме хранения базы данных.

Чтобы избежать случайного удаления сканирования, каждый раз, когда вы запускаете новое сканирование на базе существующего или закрываете программу - сканирование сохраняется.

3) Возобновляйте утерянные и остановленные краулы

У вас бывало такое, что вы в конце дня на автомате выключаете ПК, забыв о том, что сканировали огромный сайт?

Раньше, если Windows любезно решила выполнить обновление и перезапустить компьютер, отключилось питание, случился сбой программного обеспечения или вы просто забыли про регулярную проверку и выключили компьютер, сканирование было потеряно навсегда.

Цитата одного из юзеров “паука”, которая точно найдет отклик в ваших сердцах: “Разница между мной и искусственным интеллектом заключается в том, что искусственный интеллект никогда не будет настолько туп, чтобы закрыть краул, который грузился два дня и был закончен на 92%”.

У кого такого не было? Теперь, если произойдет что-то подобное, вы можете продолжить сканирование через File > Crawls.

К сожалению, невозможно гарантировать для 100% случаев, но команда разработчиков Screaming Frog Seo Spider заявляет, что в 12-ой версии обеспечила надежную подушку безопасности для таких случаев - краулы всегда сохраняются и обычно могут быть восстановлены – даже если вы выдернете шнур из розетки.

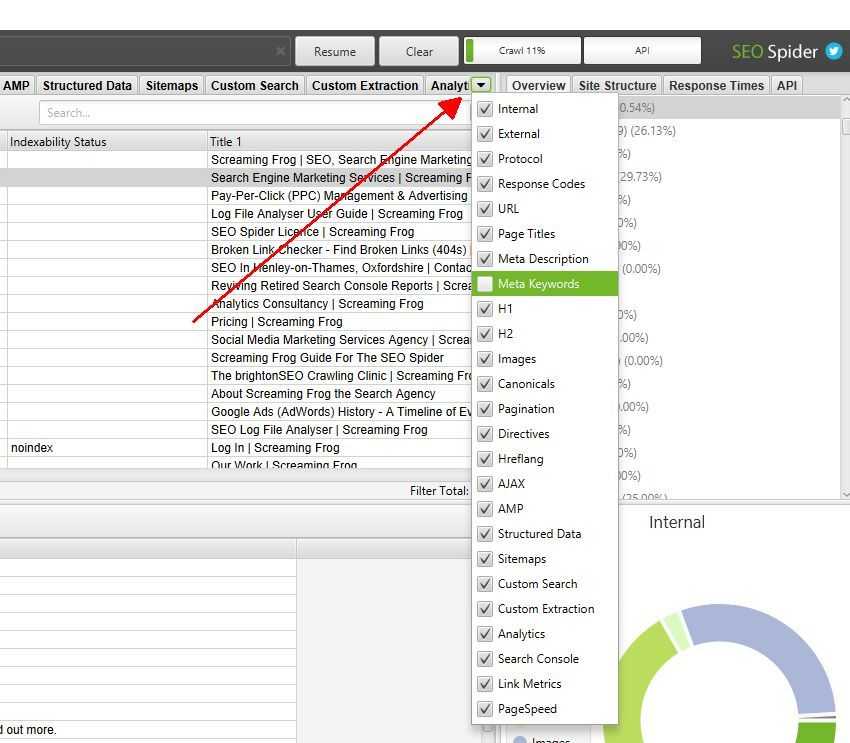

4) Настраиваемые вкладки

Теперь вы можете точно выбрать, какие вкладки отображаются и как они упорядочены в графическом интерфейсе. Прощайте мета keywords:

Вкладки можно перетаскивать и перемещать по порядку, а также их можно настроить с помощью стрелки справа от вкладок.

Это влияет только на то, как они отображаются в графическом интерфейсе, а не на то, сохраняются ли данные. Тем не менее...

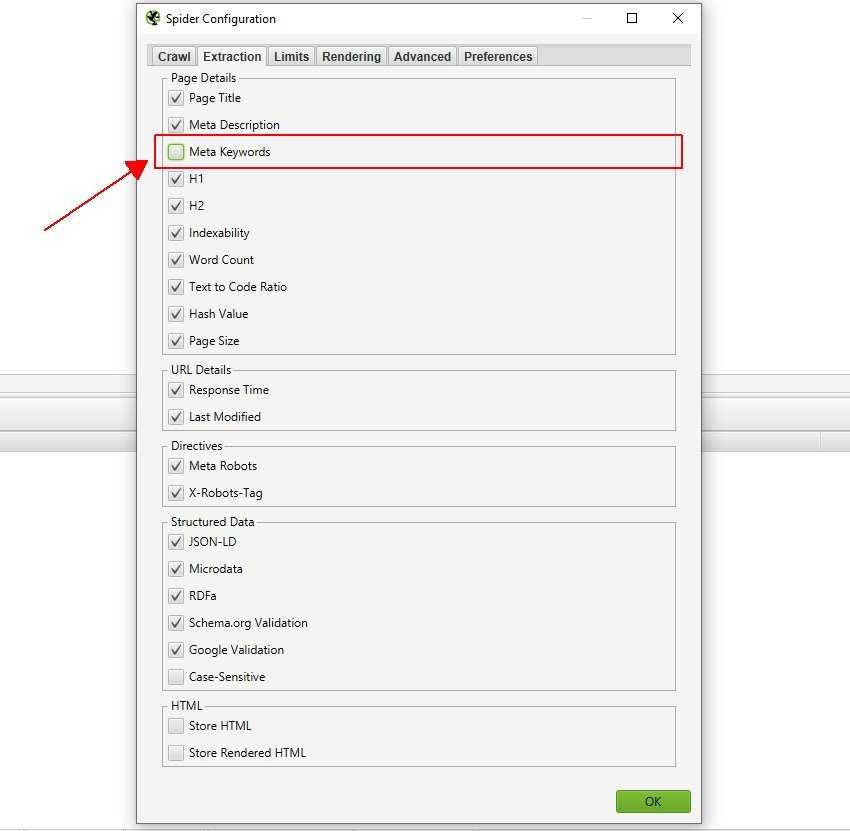

5) Выбор и настройка элементов страницы

Теперь можно убрать отдельные элементы страницы – они не будут сканировать и сохраняться в принципе, позволяя сэкономить память. Эти параметры доступны в разделе Config > Spider > Extraction. Например, если вы хотите прекратить хранение мета-тега keywords, эту настройку можно отключить.

Данный функционал позволяет сканировать только то, что вам действительно важно.

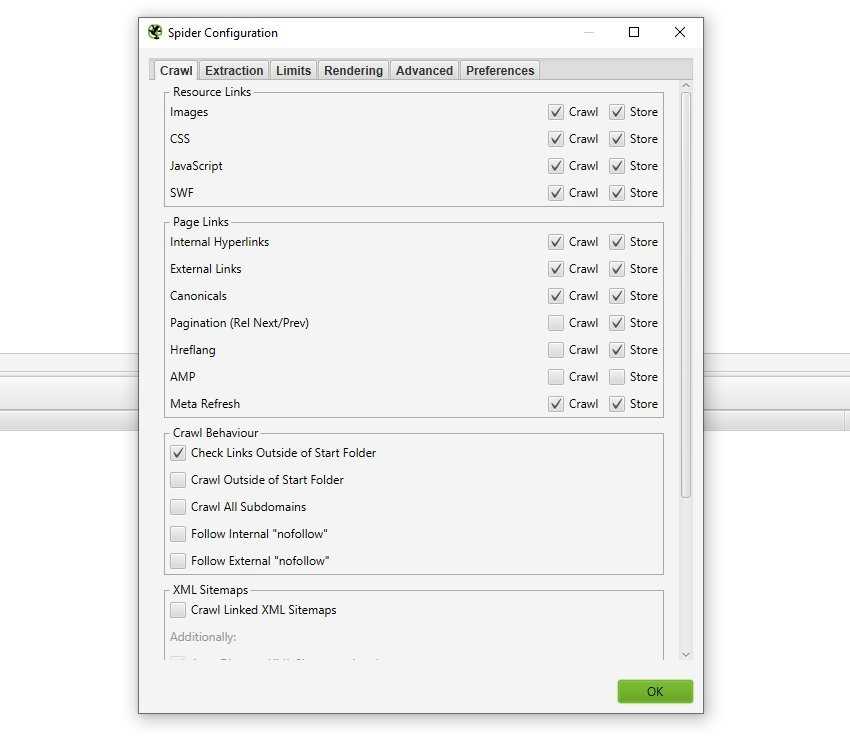

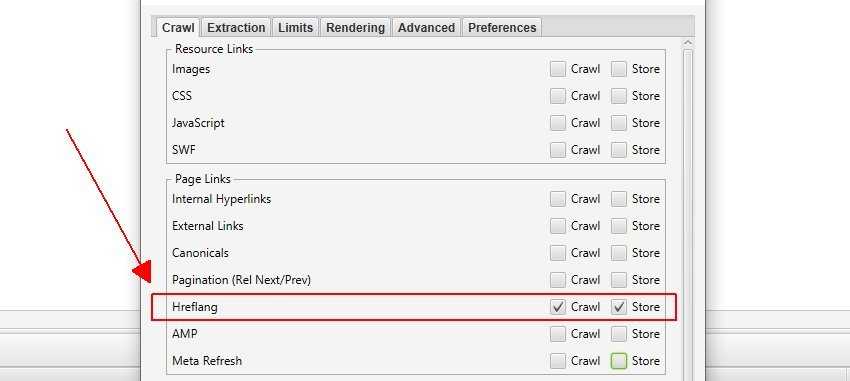

6) Настраиваемые элементы ссылок для целенаправленного аудита в режиме списка

Теперь вы можете выбрать, следует ли специально хранить и сканировать элементы ссылок (в разделе Config> Spider> Crawl).

Это делает Screaming Frog SEO Spider 12 гораздо более гибким, особенно с новым настраиваемым параметром конфигурации Internal hyperlinks. Это становится действительно мощным инструментом, в частности, в режиме списка, даже если это неочевидно поначалу.

А если вы отмените параметры «Crawl» и «Store» для всех ссылок на ресурсы и ссылок на страницы, переключитесь в режим списка (перейдите в Config > Spider > Limits и уберете лимит на глубину сканирования, которая применяется в режиме списка), вы можете проверить любой элемент ссылки, который вы хотите, наряду с URL-адресами, которые вы загружаете.

Например, вы можете ввести список URL-адресов в режиме списка и сканировать только их hreflang-ссылки.

Или вы можете ввести список URLов и проверять только их версии AMP. Или изображения. Или внешние ссылки для линкбилдинга с битыми ссылками. Ну, вы поняли :)

Ранее такой уровень контроля и точности был недоступен, поскольку удаление параметра глубины сканирования в режиме списка означало бы, что внутренние ссылки тоже будут сканироваться.

Эта расширенная конфигурация позволяет проводить тщательный контроль именно тех элементов ссылок, которые вам требуются, экономя время и силы.

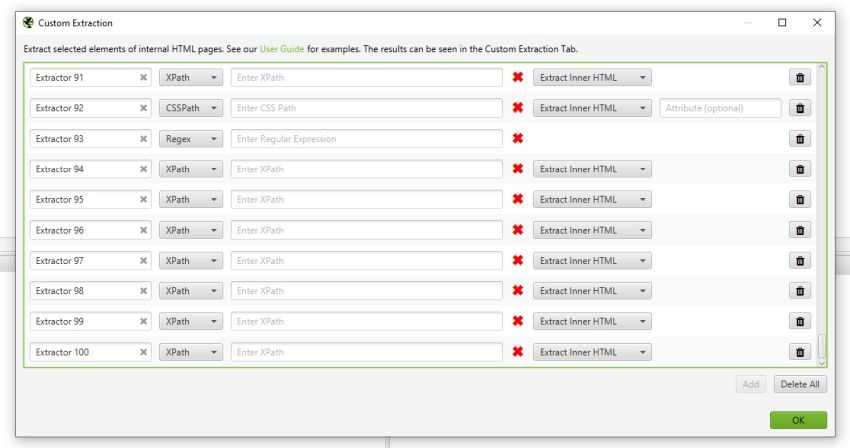

7) Больше парсеров!

Все хотели больше парсеров, так что теперь вы можете настроить до 100 с функцией Custom Extraction. Просто нажимайте «Add» каждый раз, когда вам нужен еще один.

Кстати, теперь у Custom Extraction есть собственная вкладка для более детальной фильтрации – что приводит нас к следующему апдейту...

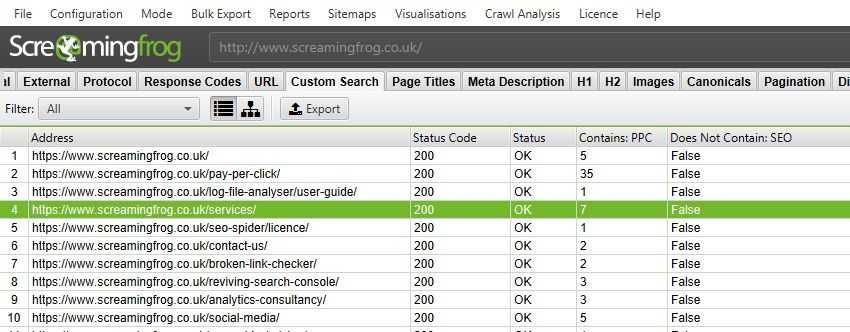

8) Улучшение пользовательского поиска

Для пользовательского поиска была выделена вкладка Custom Search, отдельная от Custom Extraction, и теперь вам доступно до 100 поисковых фильтров.

Специальная вкладка позволяет Screaming Frog SEO Spider 12 отображать все данные фильтра вместе, так что вы можете комбинировать фильтры и экспорт.

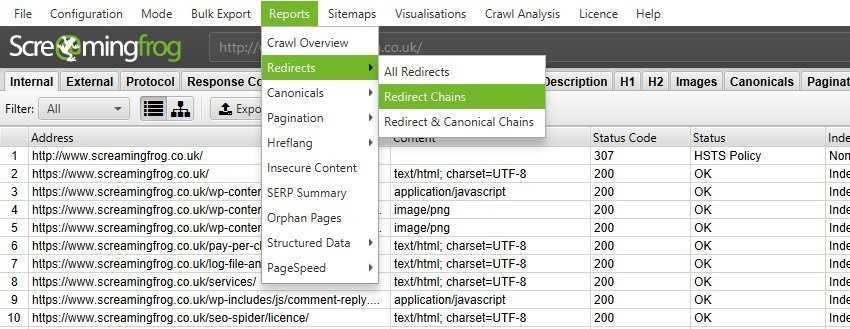

9) Дополненный отчет о цепочках редиректов (Redirect Chain Report)

Команда разработчиков учла пожелания юзеров и разделила отчет «Перенаправление и канонические цепочки» (Redirect & Canonical Chains Report) на три новых:

- «Все редиректы» (перенаправления с одним шагом и цепочки редиректов вместе);

- «Цепочки редиректов» (только перенаправления с шагом 2+);

- «Цепочки перенаправления и канонические» (перенаправления с шагом 2+ или канонические страницы в цепочке).

Все они будут работать в режиме списка во время аудита редиректов. Это должно охватывать разные сценарии, когда могут быть полезны различные данные, объединенные или разделенные.

Другие новинки

В версию Screaming Frog SEO Spider 12.0 также входит ряд небольших обновлений и фиксов:

- Появился новый столбец «Атрибуты ссылок» для внутренних и внешних ссылок. Здесь будет подробно указано, имеет ли ссылка значение nofollow, sponsored или UGC. Параметры конфигурации Follow Internal Nofollow и Follow External Nofollow будут применяться к ссылкам с атрибутами sponsored или UGC, аналогично обычной nofollow-ссылке.

- Новые директивы max-snippet, max-video-preview и max-image-preview, и для них есть фильтры на вкладке «Directives». Планируется поддержка data-nosnippet чуть позже, а пока можно анализировать с помощью Custom Extraction.

- Отчеты о сбоях будут отправляться прямо из приложения, так что вам не придется заходить на почту или загружать/отправлять журналы вручную.

- Имя краула теперь отображается в строке заголовка приложения. Если вы задали название (или задали его для файла сканирования .seospider), “паук” будет использовать смарт-имя, основанное на данном крауле. Это должно помочь при сравнении двух сканирований в разных окнах.

- Проверка структурированных данных была обновлена для использования Schema.org 3.9 и теперь поддерживает такие функции Google, как вопросы и ответы, инструкция, профессиональное обучение и фильмы. Поправлено около десятка разновидностей данных с обновленными обязательными и рекомендуемыми свойствами.

- Добавлена в интеграцию с Google Analytics.

- Параметры «Скачать XML Sitemap» и «Скачать XML Sitemap Index» в режиме списка были объединены в один параметр «Скачать XML Sitemap».

- Конфигурация exclude теперь применяется в режиме списка и по отношению к файлам robots.txt.

- Полосы прокрутки теперь удалены со скриншотов отображаемой страницы.

- Обновили эмулятор сниппетов в SERP в соответствии с последними изменениями Google по поводу увеличения шрифта на настольных компьютерах, что привело к уменьшению количества отображаемых символов перед усечением в результатах поиска. Фильтр по умолчанию для заголовков страниц «Более 65 символов» был изменен на 60. Это, конечно, можно подстроить под себя в Config > Preferences.

- Парсинг robot.txt теперь происходит существенно быстрее.

- Улучшен Custom Extraction, чтобы использовать меньше памяти.

- Добавлена поддержку x-gzip и application/gzip для сканирования карты сайта.

- Убрали краткие описания, которые всех раздражали, из первой строчки всех экспортированных файлов.

Апдейт Screaming Frog SEO Spider 12.0 от 25 октября 2019

Также выпущено небольшое обновление до версии 12.1. Этот релиз в основном исправляет мелкие ошибки и недочеты:

- Исправлена ошибка, препятствующая сохранению файлов .seospider, когда включен PSI.

- Исправлен сбой в режиме базы данных при сканировании URL-адресов длиной более 2000 символов.

- Исправлен сбой при создании скриншотов с использованием рендеринга JavaScript.

- Исправлена ошибка, из-за которой Majestic не запрашивал данные после сброса/паузы.

- Исправьте мерцание вкладки «Inlinks» во время сканирования, если выбран URL.

- Исправлен сбой повторного краулинга URL.

- Исправлена ошибка при использовании специальных символов.

- Исправлен сбой при переименовании сканирования в режиме базы данных.