E-commerce сайты больше других ощущают проблемы, возникающие с индексацией страниц и дублированным контентом. Вы продаете товары/услуги на сайте, но при этом бывают ситуации, когда на сайте появляется дублированный контент или возникают проблемы с индексацией? Вы создаете контент и проводите оптимизацию, но сайт не получает больше поискового трафика из-за проблем с индексацией?

Эта статья поможет вам избежать вышеперечисленные проблемы в будущем.

Ниже мы перечислим 4 способа устранения проблем, связанных с индексацией и дублированным контентом.

1. Знать, что находится в индексе Google

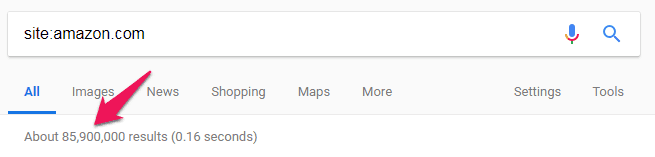

Прежде всего необходимо знать, сколько страниц проиндексировано в Google на данный момент. Вы можете сделать это с помощью поискового оператора “site:yoursite.com”.

Несмотря на то, что число проиндексированных страниц лишь ориентировочное, данный оператор позволяет определить, существуют ли какие-либо серьезные проблемы с индексацией на сайте.

Слишком маленькое количество страниц в индексе свидетельствует о наличии проблем, однако и слишком большое количество может свидетельствовать о наличии дубликатов на сайте.

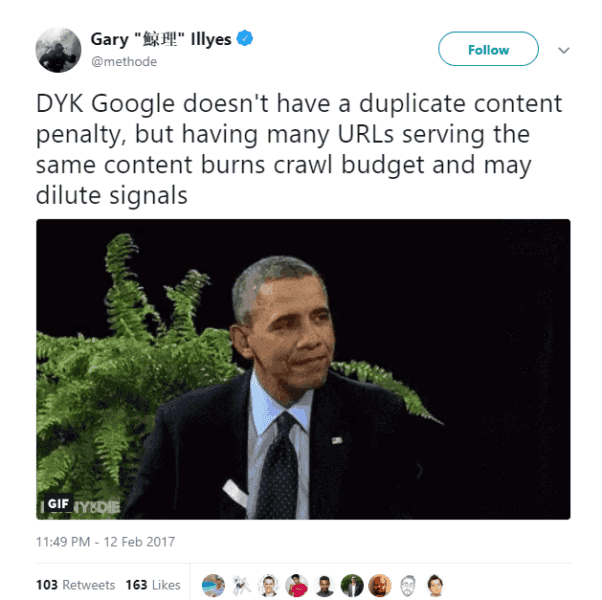

Несмотря на то, что санкции поисковых систем за дублированный контент не налагаются, такой контент способен существенно повредить ранжированию сайта в поисковой системе и, соответственно, видимости для поисковых запросов.

Если Google показывает слишком мало результатов:

- Посмотрите, какие страницы с вашей sitemap не отображаются в поисковом трафике Google Analytics.

- Проверьте общие паттерны, характерные для страниц, которые находятся не в индексе. Это могут быть проблемы с недоступностью в XML-sitemap, установка noindex или canonical тегов, проблемы или ошибки с валидацией HTML и т.д.

Если показывает слишком много результатов:

- Запустите программу для проверки страниц сайта, например Screaming Frog, SiteBulb или DeepCrawl. С помощью инструментов определите страницы с дублированным контентом.

- Определите причины возникновения дублей страниц.

2. Оптимизируйте sitemap, robots.txt и навигационные ссылки

Эти три элемента являются фундаментальными в разрезе хорошей индексации страниц, а потому должны быть настроены правильно.

Значимость карты сайта сложно переоценить. Фактически, только с её помощью Google может узнать о существовании тех или иных страниц на сайте.

Аналогично важно убедиться в том, что ваш robots.txt работает должным образом, в нем отсутствуют директивы, блокирующие индексацию и краулинг веб-страниц. Функционал robots.txt крайне важен для сайта: если он настроен неправильно или краулер Гугла не сможет получить к нему доступ, поисковая система перестает индексировать сайт.

Наконец, логически понятная схема навигации является необходимой для хорошей индексации страниц. Представители Google и Bing не раз отмечали зависимость индексации от качества навигации на сайте. Так, внимание стоит уделять иерархичности внутренних ссылок, наличию релевантных анкоров для внутренних ссылок, навигации по “хлебным крошкам” и избеганию использования тега nofollow для внутренних ссылок.

3. Правильно настраивайте параметры URL

Параметры URL позволяют определить поисковой системе необходимость использования того или иного параметра на вашем сайте. Например, если вы являетесь владельцем международного интернет-магазина, параметр country позволит пометить тот или иной регион, параметр sort может указывать на необходимость сортировки контента или порядка его выдачи на странице и т.д.

Существует множество различных параметров (пассивных и активных) URL, которые позволяют уточнять необходимость использования параметров на сайте. Во всех случаях эти параметры должны быть настроены должным образом.

4. Правильное использование noindex и каноникализации

Тег noindex сообщает поисковой системе о том, что страницу с указанным тегом не нужно индексировать, а каноникализация применяется для двух и более URL с одинаковым содержимым, среди которых только одна является “официальной” (каноничной) страницей.

Для дублей или около-дублей каноникализация является предпочтительным способом, поскольку сохраняет вес страниц. В некоторых случаях вам не понадобится, чтобы какая-либо из дублированных страниц была проиндексирована - в таком случае рекомендуется использовать noindex.

Также мы рекомендуем применять каноникализацию в том случае, если вы проводите A/B-тестирование страниц - в таком случае тег canonical должен применяться к самой главной странице.

Мы рекомендуем использовать тег noindex для следующих страниц: страницы авторизации команды сайта, страниц “Корзина”, результатов внутреннего поиска по сайту, дублей, которые могут быть каноникализированы и уникальных категорий продуктов.

Заключение

Таким образом, использование четырех вышеперечисленных способов позволит избежать проблем с индексацией в поисковой системе и убрать из “глаз” поисковых систем дублированный контент, который способен навредить ранжированию сайта.